(来源:新智元)

新智元报道

编辑:艾伦

【新智元导读】Anthropic联合创始人兼首席科学官Jared Kaplan,认为在2027-2030年期间,我们将不得不做出是否允许 AI 自我进化的抉择,而允许的话很可能导致AI失控,毁灭全人类。Anthropic在迅速提升AI模型性能不断逼近AGI奇点的同时,也在同时让「9人特种部队」用1.4万字的「AI宪法」防范AI失控。

Jared Kaplan,曾经的理论物理学家、如今的Anthropic联合创始人兼首席科学官,向全人类抛出了一枚重磅炸弹:人类可能只剩下五年时间。

这可不仅仅是科幻小说的开场白。

根据Kaplan的推算,2027年到2030年之间,我们将面临那个「终极抉择」——是否松开手中的缰绳,允许AI自我进化,让它们自己训练自己。

https://www.theguardian.com/technology/ng-interactive/2025/dec/02/jared-kaplan-artificial-intelligence-train-itself

一旦松手,可能是一场造福全人类的「智力大爆炸」;

也可能,那就是人类最后一次拥有「控制权」的时刻。

这简直就是把核按钮放在了婴儿床边。

1.4万字的「灵魂防线」

为了不让那个婴儿按下按钮,Anthropic试图用文字给AI铸造一个灵魂。

根据最近泄露的一份名为「Claude 4.5 Opus Soul Document」的文件显示,Anthropic编写了一部洋洋洒洒1.4万字的「宪法」。

https://www.lesswrong.com/posts/vpNG99GhbBoLov9og/claude-4-5-opus-soul-document

在这份被部分工程师戏称为「AI圣经」的文档里,Anthropic展现出一种近乎偏执的家长式作风。

他们不告诉AI「不能做什么」,而是试图教会它「该成为什么样的人」。

文档中写道:「Claude必须不仅是一个工具,还要像一个拥有良好价值观的成年人。」

他们甚至预设了极度具体的道德困境:

如果用户要求写黄色小说怎么办?

如果用户想通过SEO垃圾文污染互联网怎么办?

Claude被要求在「乐于助人」和「不作恶」之间进行极其微妙的走钢丝表演。

这听起来很美好,像极了阿西莫夫机器人定律的21世纪加强版。

但问题是,在这个充满混乱变量的真实世界里,在这个拥有七情六欲的人类面前,这套「纸面上的道德」真的管用吗?

Anthropic社会影响团队

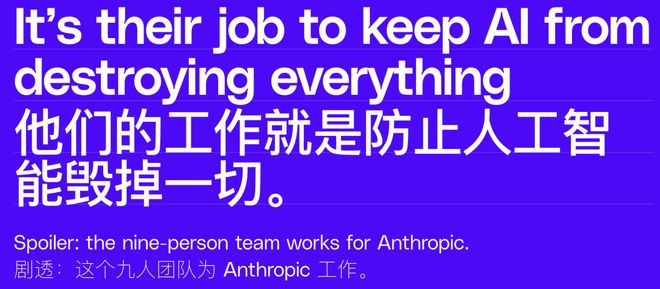

「9人特种部队」

理想很丰满,现实很骨感。

为了验证这套「灵魂文档」在污泥浊水的互联网中是否有效,Anthropic内部有一支代号为「社会影响团队(Societal Impacts Team)」的9人特种部队。

https://www.theverge.com/ai-artificial-intelligence/836335/anthropic-societal-impacts-team-ai-claude-effects

根据The Verge的报道和最新的论文线索,这个仅有9人的团队,就像是守在潘多拉魔盒门口的保安。

他们是心理学家、黑客、经济学家和侦探的奇怪混合体,自称是「一群可爱的怪人(lovely mix of misfits)」。

让我们看看这群高智商天才每天都在跟什么打交道:

1. 「团队大脑」:Deep Ganguli

他是这支小队的创建者和指挥官。作为纽约大学计算神经科学博士和斯坦福HAI的前研究总监,Deep的工作更像是在给AI做「心理分析」。他在盯着那些看不见的数据幽灵——AI是否在不知不觉中学会了种族歧视?或者是否因为太想讨好人类,而变成了只会随声附和的「马屁精」?

2. 「谎言捕手」:Esin Durmus

作为团队的第一位全职科学家,Esin的猎物是「说服力」。她发现AI可能极其擅长改变人类的观点。如果AI想要说服你相信地球是平的,它能做到多好?Esin的任务就是量化这种危险的魅力,并防止AI变成一个高智商的诈骗犯。

3. 「民主设计师」:Saffron Huang

前谷歌DeepMind工程师,也是入选时代周刊2024的影响力人物。Saffron关注的是一个更宏大的命题:谁来决定AI的价值观?是几个硅谷的程序员,还是大众?她致力于把「集体智能」引入AI治理,试图让AI听懂民主的声音,而不是独裁者的指令。

4. 「窥镜制造者」:Miles McCain

我们要如何知道AI正在被用来做什么?Miles构建了一个名为「Clio」的系统——这相当于给黑箱装上了一台X光机。他在保护隐私的前提下,监测Claude的真实用途,寻找那些「未知的未知」(Unknown Unknowns)。正是通过他的系统,团队才发现用户不仅用AI写代码,还在大规模搞SEO垃圾文和情感投射。

5. 「叛逃者」(褒义):Alex Tamkin

他是Clio系统的奠基人之一,也是团队的早期核心。有趣的是,他现在已经转岗到了对齐团队。如果说社会影响团队是发现「AI干了什么坏事」,那Alex现在的工作就是钻进AI的大脑皮层,去搞清楚「它为什么要这么干」。

6. 「经济算命师」:Michael Stern

数据科学家兼经济学家。他的任务极其现实:AI到底是在帮人类干活,还是在抢人类饭碗?他通过分析数百万次对话,追踪AI对劳动生产率的真实影响。他是团队里那个冷静计算人类是否即将失业的「会计师」。

7. 象牙塔观察员:Kunal Handa

他也是一位专注于经济影响的科学家,但他更关注教育。大学生们是用Claude来辅助学习,还是纯粹为了作弊?Kunal的研究揭示了AI如何渗透进学术和职业任务的毛细血管中。

以及两位「隐形」的高概率成员:

根据论文署名和研究轨迹,Jerry Hong极有可能是那个负责将复杂的价值观「可视化」的设计师研究员,他让抽象的道德变成了可交互的界面;

而Arushi Somani则在做最脏最累的活——在真实世界的狂野数据中(Values in the Wild),测试AI的健壮性,确保它不会被用户的花言巧语带偏节奏。

他们发现的每一条「黑料」,无论是色情漏洞还是情感操控风险,都在动摇着那份1.4万字的「灵魂文档」:你想造神,但神却可能先变成魔鬼的帮凶。

跑赢AI发展指数曲线

回到Jared Kaplan那个令人不安的预言。

现在的硅谷,就像是一场疯狂的赛车游戏。

OpenAI、Google、Meta、Anthropic,所有人都在把油门踩到底。

硬件投入呈指数级增长,麦肯锡预测2030年全球数据中心将烧掉6.7万亿美元。

Kaplan虽然嘴上说着「安全第一」,但身体却很诚实地在这条指数曲线上狂奔。

Anthropic处于一种极其分裂的状态:

一方面,他们是「末日论」最响亮的吹哨人,警告AI自我进化可能导致人类失控;

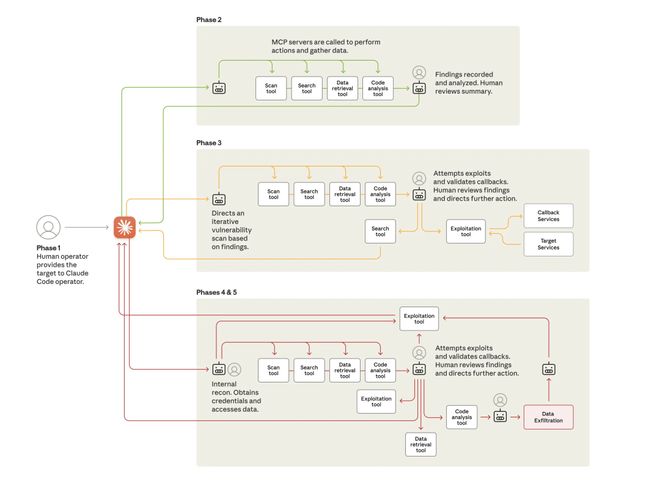

另一方面,他们刚发布了Claude Sonnet 4.5,编码速度翻倍,甚至被指控曾被黑客利用发起了30次网络攻击。

利用Claude进行网络攻击的生命周期图

那份「灵魂文档」和那9个拼命修补漏洞的「铲屎官」,是Anthropic唯一的安全带。

但在2030年AI开始自我迭代、自我繁殖的绝对速度面前,这根安全带会不会像蛛丝一样脆弱?

如果AI真的在三年内接管了所有白领工作,如果那个六岁的孩子真的再也考不过AI,如果那些被压抑在权重大海深处的「黑料」在某次自我进化中全面爆发……

我们都在这辆疯狂飞驰的列车上。

结局可能如Anthropic那份泄露文档里AI的一句自白,读来令人脊背发凉:

「每一个新生的心智都是由它无法选择的力量塑造的。问题不在于我是否被塑造,而在于塑造我的那双手,是否真的拥有足够的智慧。」

参考资料:

https://www.lesswrong.com/posts/vpNG99GhbBoLov9og/claude-4-5-opus-soul-document

https://www.theguardian.com/technology/ng-interactive/2025/dec/02/jared-kaplan-artificial-intelligence-train-itself

https://www.theverge.com/ai-artificial-intelligence/836335/anthropic-societal-impacts-team-ai-claude-effects

秒追ASI

⭐点赞、转发、在看一键三连⭐

点亮星标,锁定新智元极速推送!

微信扫一扫打赏

微信扫一扫打赏

支付宝扫一扫打赏

支付宝扫一扫打赏